本文介绍了北京大学人工智能研究院朱毅鑫助理教授团队与北京通用人工智能研究院黄思远研究员团队联合在 CVPR 2025 会议上发表的论文,题为 Dynamic Motion Blending for Versatile Motion Editing。

该研究提出了一个通用人物动作编辑方法,实现了仅通过文本指令进行多种类型的动作编辑,如肢体动作替换,动作微调,和风格迁移。论文的第一作者是北京大学人工智能研究院博士生蒋楠(导师朱毅鑫)、北大智班本科生李弘杰,和北大信科本科生袁子烨。论文通讯作者为朱毅鑫助理教授和黄思远研究员。论文作者还包括北京通用人工智能研究院研究员陈以新、刘腾宇,以及北大通班本科生何子默。

图1. 本文方法实现了通过文本指令进行多种类型的动作编辑

人工智能驱动的动作编辑是指通过 AI 技术对已有的人物动作数据进行有针对性的修改和调整,而不必重新捕捉或制作整个动作序列。这项技术允许创作者保留原始动作所具有的含义,同时根据需要做特定身体部位动作的替换、改变整体风格(如将正常走路变为疲惫的走路),和调整动作幅度等。在传统动画制作流程中,这类编辑需要专业动画师手动逐帧调整,耗时且技术要求高。而人工智能驱动的动作编辑则可以通过自然语言指令实现快速、直观的修改,极大提高了内容创作效率。

目前基于AI的文本引导动作编辑技术虽然取得了一定进展,但仍面临很多尚未解决的问题。首先,现有方法只能处理训练中见过的固定模式,需要成对的"原始动作-修改后动作-修改文本指令"三元组用于训练模型,无法应对训练中未见过的新的组合,缺乏在更广泛场景的应用潜力。其次,编辑后的动作也常常出现不自然的"机器人感"——动作之间的衔接生硬,身体各部位之间缺乏协调。

针对这些挑战,我们设计了 MotionReFit 框架,首先通过 在线数据增强技术合成大量训练数据,突破了之前的方法对训练集中有限的三元组的依赖;然后通过专门的动作协调器引导扩散模型生成自然连贯的动作。我们的方法不仅提高了模型对新指令和动作组合的泛化能力,还显著增强了编辑后动作的协调性和真实感,使 AI 驱动的动作编辑技术更接近实际应用需求。

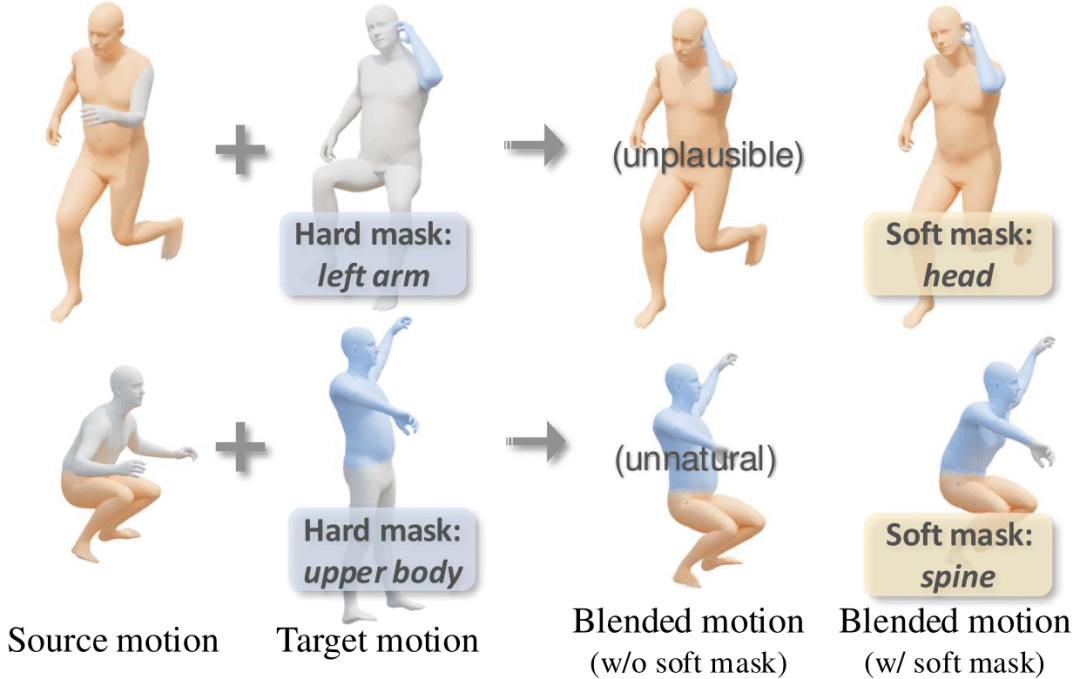

为了解决动作编辑模型依赖大量标注数据的限制,我们提出了 MotionCutMix 在线数据增强技术。MotionCutMix 通过身体部位动作组的合方式,利用未标注的大型动作数据和少量的文本-动作数据对合成新的训练样本。具体而言,该方法随机选择源动作和目标动作,然后使用软掩码机制进行动作混合,生成原始动作-编辑动作-指令的合成三元组。软掩码机制在硬掩码的基础上,增加了过渡关节的平滑插值,有效消除了动作部位之间组合不自然的问题。这种动态数据增强策略显著扩展了训练分布,使模型能够从有限的标注数据中学习更广泛的编辑模式,在语义编辑(如身体部位替换)和风格编辑(如情绪变化)任务中均显著提高了方法的表现。实验证明,即使仅使用10%的标注数据,配合 MotionCutMix 训练的模型仍能保持接近全数据训练的性能。

图2:MotionCutMix通过随机融合多个部位的动作,实现大规模的数据增强

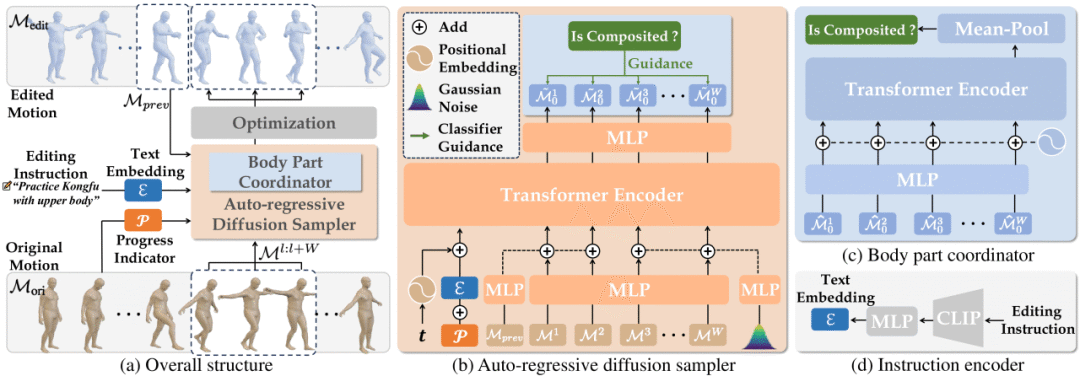

研究团队同时提出了 MotionReFit,一个自回归的条件扩散生成模型。MotionReFit 采用滑动窗口机制,将长序列源动作分解为固定长度的片段逐一处理,每次生成时保留前两帧作为上下文信息,确保动作编辑的时间连续性。这种自回归设计的另一优势为有效简化了学习空间,同时使模型能够处理任意长度的动作序列。为应对动作合成可能带来的身体部位协调性问题,我们引入了动作协调器组件,该组件是一个经过特殊训练的判别器,能够识别动作片段是否为人工合成。在扩散采样的最后阶段,动作协调器通过分类器引导机制,自动调整生成的动作以确保肢体间的协调性,避免出现走路顺拐等不自然现象。此外,MotionReFit 还整合了多种条件信息,包括文本指令的 CLIP 编码、扩散时间步和序列进度指示器,使模型能够精确遵循用户指令并生成流畅自然的编辑动作。

图3. MotionReFit基于自回归的条件扩散生成模型,进行可控动作编辑

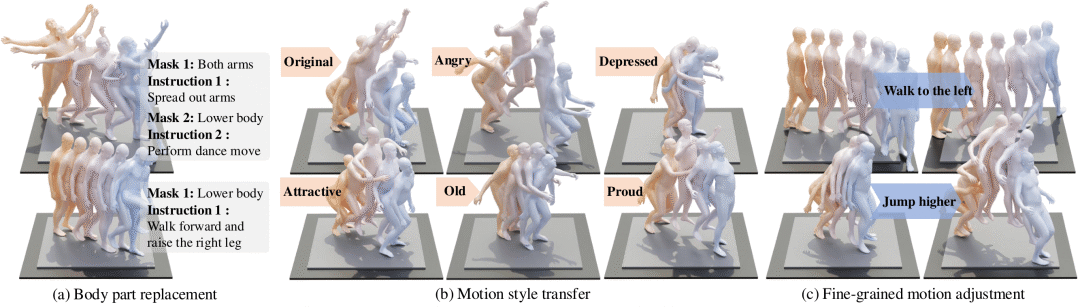

为支持多样化的动作编辑任务,研究团队还开发了 STANCE (Style Transfer, Fine-Grained Adjustment, and Body Part Replacement) 数据集,涵盖了三类常见的动作编辑需求:

身体部位替换任务关注对特定身体部位动作的精确修改,例如"将右手挥动改为摆动"或"将双腿动作从走路改为跑步"。为构建这部分数据,我们标注了13,000个动作序列。每个序列标注了精确的身体部位掩码(如头部、躯干、四肢等)以及相应的动作描述。

动作风格转换任务的目标为保留动作含义的同时改变其表现风格,如将"正常走路改为疲惫走路"或"平静手势变为愤怒手势"。为构建训练数据,我们邀请了经验丰富的动作捕捉演员演绎同一动作的不同情绪和风格变体,总计收集了约2小时的风格化动作捕捉数据,涵盖喜悦、悲伤、疲惫等多种动作风格。

细粒度动作调整任务关注更微妙的动作特性修改,如动作的幅度、力度等,例如"走得更快"或"挥手幅度更大"。为此,我们构建了4500个动作对与编辑描述的三元组,并利用大型语言模型辅助生成自然语言描述,随后由人类专家审核确保质量。

这一综合数据集通过系统性地覆盖从局部到整体、从显式到隐晦的各类动作编辑需求,为动作编辑研究提供了丰富的训练和评估资源。数据集的多样性和高质量标注也为模型学习更自然、更符合人类理解能力的动作编辑能力奠定了基础。

图4:STANCE动作编辑数据集

实验结果表明,MotionReFit 在保持动作自然度的同时,能够准确执行各类编辑指令。与现有方法相比,该框架在多个评估指标上取得了显著提升。在身体部位替换任务中,模型展现出更低的 FID(衡量生成质量的指标)和更高的编辑准确性;在风格转换任务上,系统性能提升更为明显,无论是动作质量还是编辑精确度都实现了大幅飞跃。值得注意的是,即使在有限数据场景下,MotionReFit 仍然保持了较高性能,这有力证明了 MotionCutMix 训练技术的有效性和适应性,为低资源环境下的动作编辑技术应用提供了可能。

论文提出了一个仅通过原始动作和文本指令实现动作编辑的框架,开发了显著提高模型泛化能力和数据利用效率的 MotionCutMix 动作数据增强技术,构建了为动作编辑研究提供丰富资源的 STANCE 数据集,实现了空间和时间编辑能力的统一。我们计划在未来工作中进一步提高模型的时空理解能力,以处理更复杂的动作序列和编辑指令,并引入基于物理的约束确保动作的物理合理性。